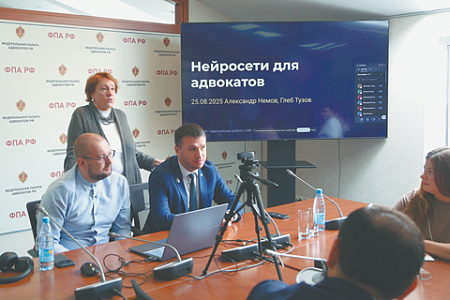

Федеральная палата адвокатов РФ готовит рекомендации по юридически корректному применению ИИ. Фото с сайта www.fparf.ru

Федеральная палата адвокатов РФ готовит рекомендации по юридически корректному применению ИИ. Фото с сайта www.fparf.ru

В Федеральной палате адвокатов (ФПА) РФ создана рабочая группа для обсуждения проблем применения искусственного интеллекта (ИИ) в юридической практике. По словам экспертов «НГ», проникновение ИИ в правовую сферу ставит перед адвокатурой серьезные вызовы. Главный вопрос – кто и в каком порядке должен нести ответственность за ошибочные рекомендации или даже выводы нейросетей.

Рабочая группа по проблемам ИИ, созданная в ФПА, судя по всему, стала ответом на эксперименты с правовыми консультациями у нейросетей. Современные технологии упрощают рутинную сторону работу юриста, позволяя анализировать большие объемы информации, например, о нормативном регулировании или судебной практике либо составлять шаблоны документов.

Однако применение ИИ порождает и ряд коллизий, связанных прежде всего с погрешностями существующих систем. Характерный пример – это ошибки «умных» камер при фиксации нарушений ПДД, которые уже распознавали игрушки в салоне автомобиля как непристегнутых пассажиров или не фиксировали ремни безопасности детских кресел. Причем споры по подобным делам уже доходят до высших судебных инстанций, которые и выявляют подобные ошибки.

Вице-президент ФПА Сергей Зубков рассказал «НГ», что одним из направлений деятельности рабочей группы как раз и станет оценка применения средств автоматизации для фиксации различных правонарушений в сфере дорожного движения. «По итогам этой аналитической работы мы выработаем рекомендации для адвокатов, которые будут помогать водителям, оказавшимся в ситуации необоснованного привлечения к ответственности», – пояснил он. Потому что хотя установленный порядок и требует, чтобы каждое нарушение, зафиксированное камерой, было подтверждено инспектором, на практике «фактически все в безусловном порядке выставляются водителям для привлечения к ответственности». Несмотря на самые очевидные и при этом довольно распространенные ошибки, которые связаны в первую очередь с тем, что инспектор, проверяющий достоверность информации от камеры, просто не был должным образом внимателен.

Впрочем, для адвокатского сообщества не менее важный вопрос – это сохранность профессиональной тайны и безопасность персональных данных доверителей при использовании нейросетей. Как сказал «НГ» адвокат коллегии адвокатов «Диктатура Закона» Артем Багдасарян, при внедрении ИИ в юридическую сферу проблемы связаны не столько с самими этими технологиями, сколько с попытками заменить ими профессиональный правовой анализ. То есть когда нейросеть перестают воспринимать как чисто вспомогательный инструмент.

Потому что одна из наиболее частых и опасных ситуаций, по его словам, – это ошибки ИИ с правоприменением. Алгоритмы нередко опираются на неактуальные редакции законов, утратившие силу судебные акты или усредненную практику. А в уголовном и административном процессе такие ошибки могут напрямую отразиться на судьбе человека, спровоцировав, к примеру, неверную квалификацию деяния, неправильную оценку сроков давности, подсудности или процессуальных гарантий. «И особую тревогу вызывает то, что подобные ошибки зачастую неочевидны для пользователя, наоборот, они воспринимаются как «объективное» или «нейтральное» мнение машины», – заметил Багдасарян.

И, конечно, пояснил он, при использовании общераспространенных ИИ-сервисов возникает риск передачи конфиденциальной информации третьим лицам и ее последующего использования вне контроля адвоката, чего не избежать даже при обезличивании данных, поскольку есть возможность восстановления контекста конкретного дела. «Фактически адвокат, не до конца понимающий, где и как обрабатываются загруженные данные, рискует нарушить базовый профессиональный стандарт», – подчеркнул Багдасарян. Но еще более серьезные вопросы, по его мнению, возникают к следственным и правоохранительным органам, допустим, загружающим в ИИ-программу материалы уголовных дел для их анализа, составления процессуальных документов или оценки доказательств, что может привести к нарушению тайны следствия. Так что здесь «цифровизация из инструмента повышения эффективности легко превращается в источник процессуальных нарушений, которые впоследствии ставят под сомнение допустимость доказательств».

Если же говорить о судах, то практика показывает, что автоматизированные системы распределения дел, шаблонные судебные акты, автоматическая проверка процессуальных сроков и оснований для отказа в принятии жалоб могут ускорять их работу, но одновременно повышают риск формального правосудия. «Там, где требуется оценка жизненной ситуации, мотивов, личности обвиняемого или доверия к доказательствам, механическое применение алгоритмов способно привести к заведомо несправедливым решениям», – заявил «НГ» Багдасарян. И добавил, что для адвокатов это усложняет выстраивание защиты: приходится преодолевать не только позицию конкретного должностного лица, но и «логику такой системы», которая не склонна к сомнениям, гибкости и пересмотру исходных данных. «Основной риск сегодняшнего этапа цифровизации заключается в иллюзии безошибочности ИИ. Но пока тот не обладает ни юридической ответственностью, ни пониманием принципов справедливости, его применение в судах и правоохранительной системе должно быть строго ограничено вспомогательными функциями», – настаивает он. Любые решения, затрагивающие права и свободы человека, должны оставаться результатом осмысленного и персонального анализа, за который конкретное должностное лицо или судья несут ответственность.

Как подтвердил «НГ» управляющий партнер адвокатского бюро «Немовы и партнеры» Александр Немов, ИИ обязательно нужно проверять, поскольку его нельзя считать гарантированно надежным источником информации или идей. Все еще остаются случаи с выдумыванием источников либо ссылками на сомнительные: «Нейросеть может выдумать судебную практику и очень аргументированно доказывать свою правоту, приводя даже будто цитаты из решения суда. Такое встречается сплошь и рядом». При этом «бездумное перекидывание в нейросеть документов, не убрав персональных данных или сведений, нарушающих адвокатскую тайну, – это серьезное нарушение закона. Однако, указал Немов, анонимизация данных – это отдельная и сложная работа, выполнение которой приводит к таким затратам времени, которые нивелируют главный плюс ИИ – скорость выполнения рутинных задач.

Напомним, что еще год назад в адвокатском сообществе были более оптимистические воззрения на возможности применения ИИ, теперь там смотрят на быстрый прогресс современных технологий с явно более высокой опаской. Возможно, потому, что уже сейчас, по словам Немова, поменялось поведение доверителей, которые «стали параллельно с адвокатом консультироваться с ИИ и сообщать ему мнение нейросети с просьбой прокомментировать». Да и «неопытные, начинающие юристы и адвокаты, которые применяет ИИ, уже создают конкуренцию опытным коллегам, не использующим нейросети, по скорости работы, генерации идей при выполнении поручений клиентов». Впрочем, Немов привел «НГ» и прекрасный, по его мнению, пример – электронное распределение дел между судьями. «Полностью исключены коррупционные факторы. И никто не сможет никогда более упрекнуть, что дело как-то «специально» попало к конкретному судье. Хотя, конечно, и это условие действует только при реальном исключении человеческого фактора из цифровизации», – отметил адвокат.